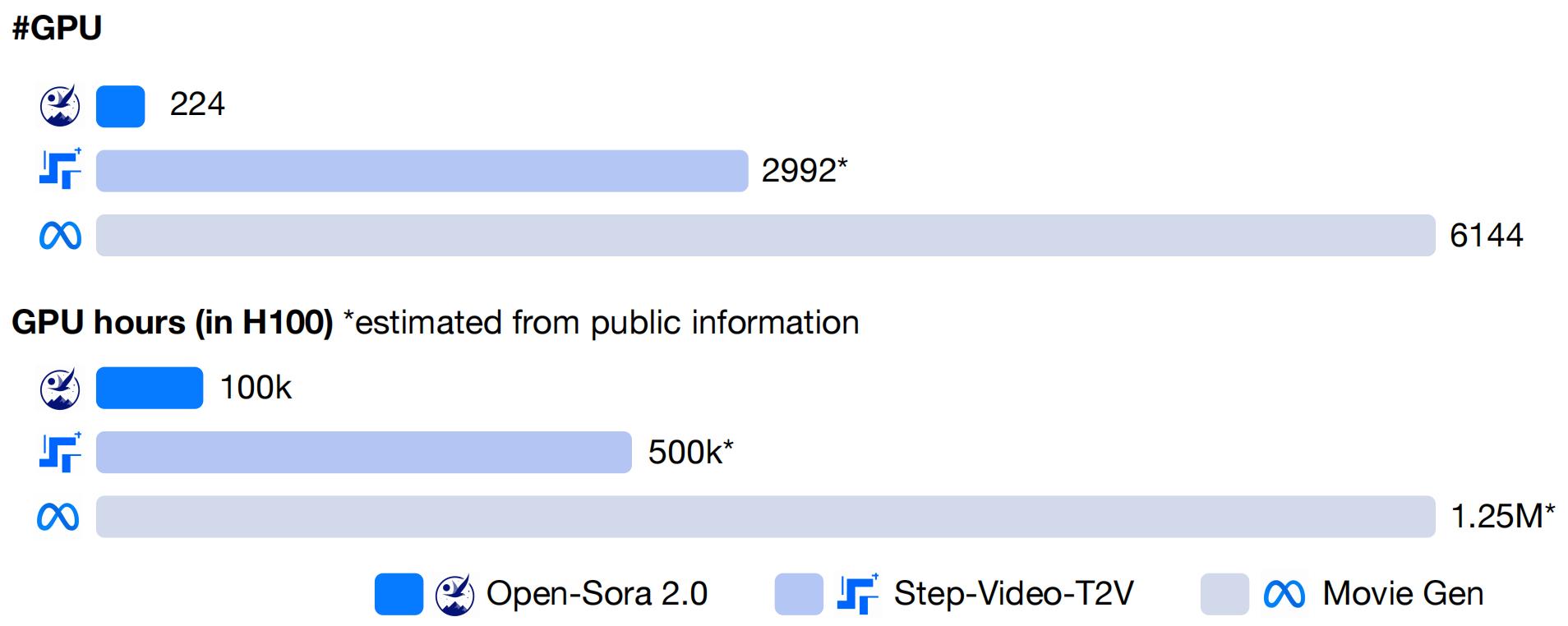

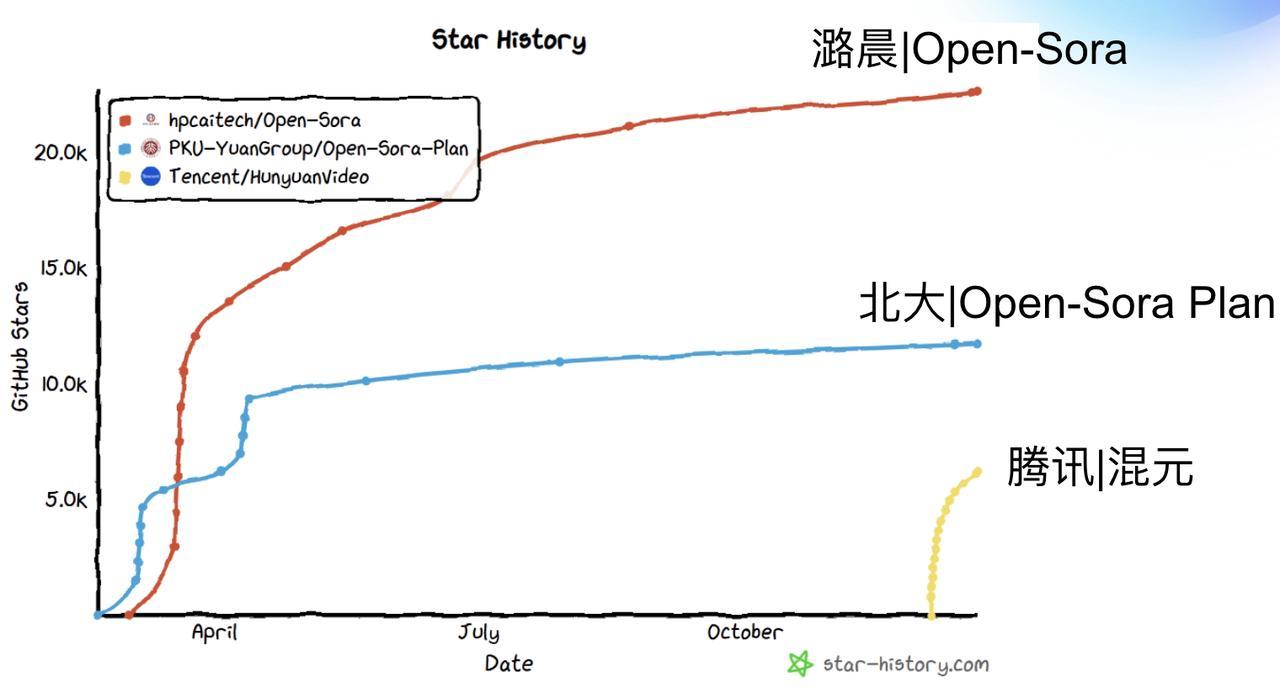

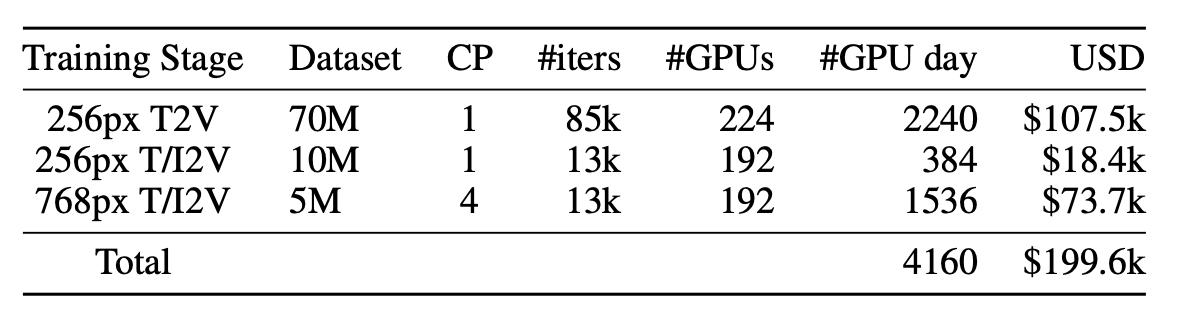

Open-Sora 2.0—— 全新开源的 SOTA(State-of-the-Art)视频生成模型正式发布,仅用 20 万美元(224 张 GPU)成功训练出商业级 11B 参数视频生成大模型,性能直追 HunyuanVideo 和 30B 参数的 Step-Video。权威评测 VBench 及用户偏好测试均证实其卓越表现,在多项关键指标上媲美动辄数百万美元训练成本的闭源模型。此次发布全面开源模型权重、推理代码及分布式训练全流程,让高质量视频生成真正触手可及,进一步提升视频生成的可及性与可拓展性。

开源仓库:https://github.com/hpcaitech/Open-Sora

11B 参数规模媲美主流闭源大模型:

-

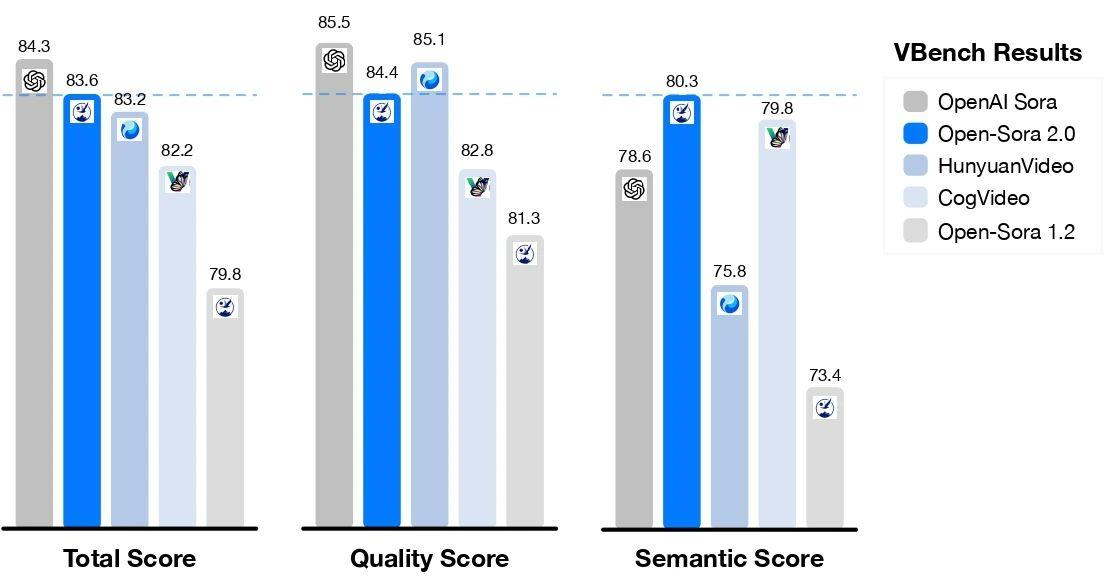

媲美 HunyuanVideo 和 30B Step-Video:Open-Sora 2.0 采用 11B 参数规模,训练后在 VBench 和人工偏好(Human Preference) 评测上都取得与用高昂成本开发的主流闭源大模型同等水平。

-

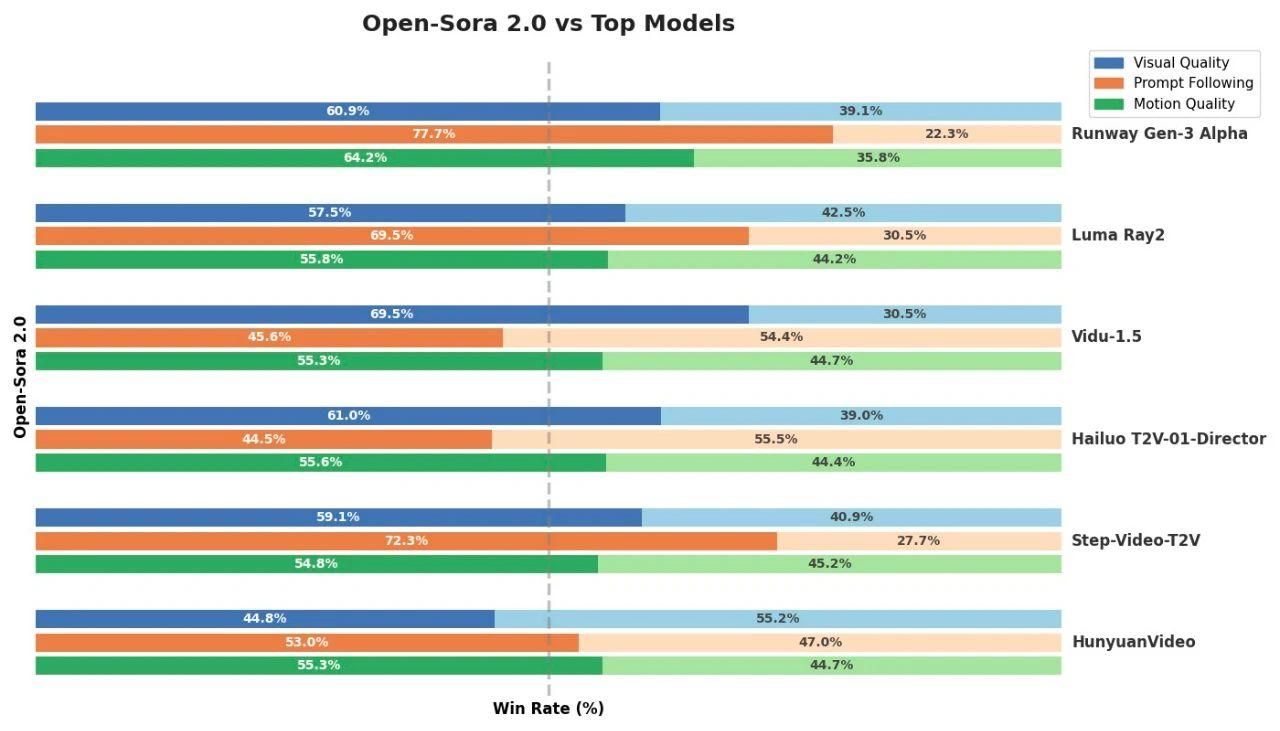

用户偏好评测:在视觉表现、文本一致性和动作表现三个评估维度上,Open Sora 在至少两个指标上超越了开源 SOTA HunyuanVideo,以及商业模型 Runway Gen-3 Alpha 等。以小成本获取了好性能。

-

VBench 指标表现强势:根据视频生成权威榜单 VBench 的评测结果,Open-Sora 模型的性能进步显著。从 Open-Sora 1.2 升级到 2.0 版本后,与行业领先的 OpenAI Sora 闭源模型之间的性能差距大幅缩小,从之前的 4.52% 缩减至仅 0.69%,几乎实现了性能的全面追平。此外,Open-Sora 2.0 在 VBench 评测中取得的分数已超过腾讯的 HunyuanVideo,以更低的成本实现了更高的性能,为开源视频生成技术树立了全新标杆!

低成本训练与高效能优化:

模型架构:

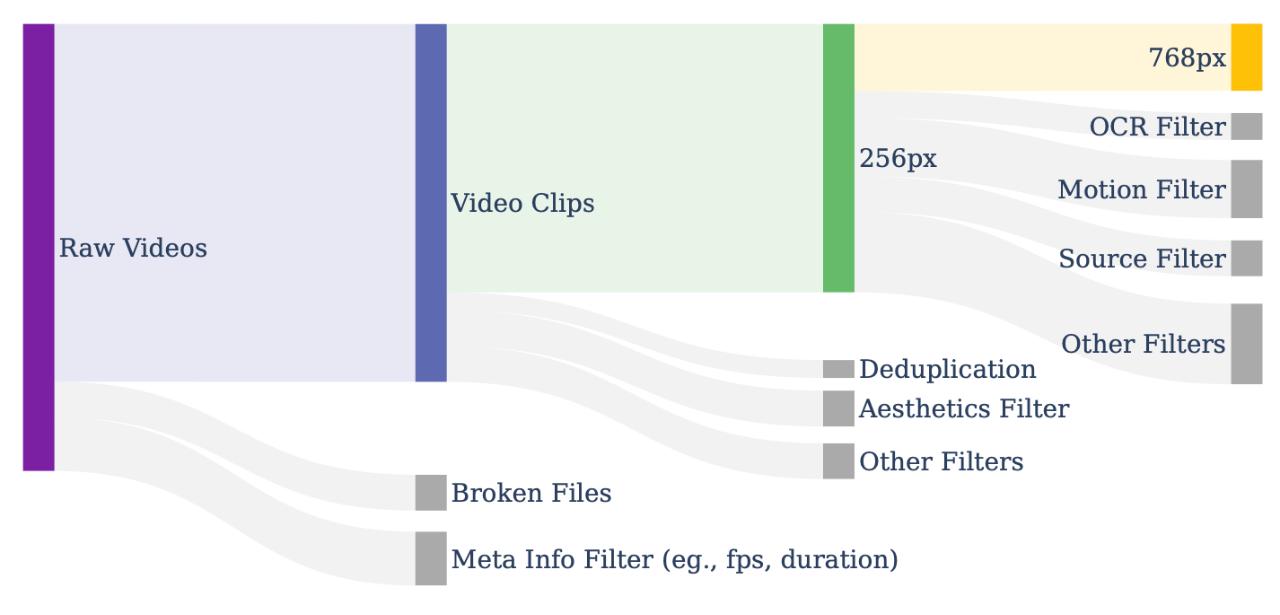

Open-Sora 2.0 延续 Open-Sora 1.2 的设计思路,继续采用 3D 自编码器和 Flow Matching 训练框架,并通过多桶训练机制,实现对不同视频长度和分辨率的同时训练。在模型架构上,引入 3D 全注意力机制,进一步提升视频生成质量。同时,采用最新的 MMDiT 架构,更精准地捕捉文本信息与视频内容的关系,并将模型规模从 1B 扩展至 11B。此外,借助开源图生视频模型 FLUX 进行初始化,大幅降低训练成本,实现更高效的视频生成优化。

高效训练方法和并行方案全开源:

-

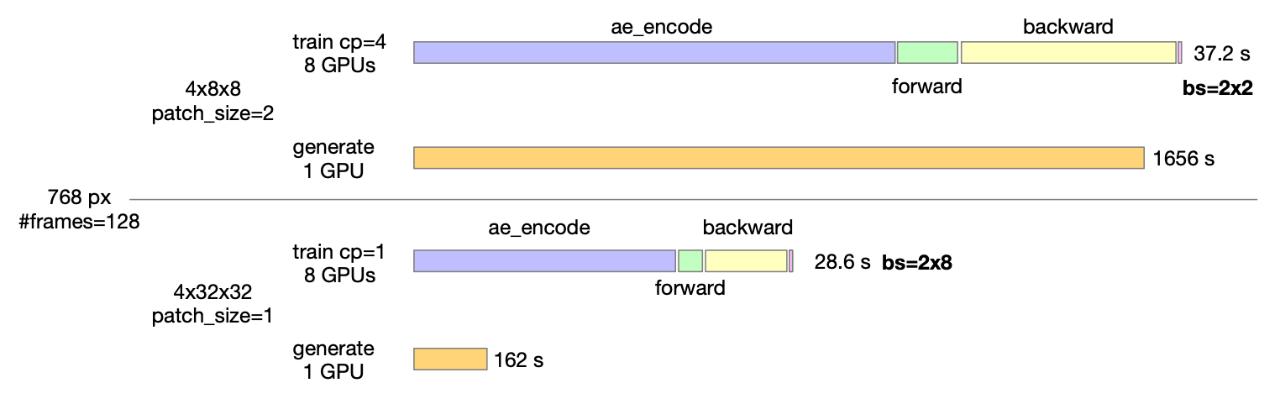

高效的序列并行和 ZeroDP,优化大规模模型的分布式计算效率。

-

细粒度控制的 Gradient Checkpointing,在降低显存占用的同时保持计算效率。

-

训练自动恢复机制,确保 99% 以上的有效训练时间,减少计算资源浪费。

-

高效数据加载与内存管理,优化 I/O,防止训练阻塞,加速训练流程。

-

高效异步模型保存,减少模型存储对训练流程的干扰,提高 GPU 利用率。

-

算子优化,针对关键计算模块进行深度优化,加速训练过程。

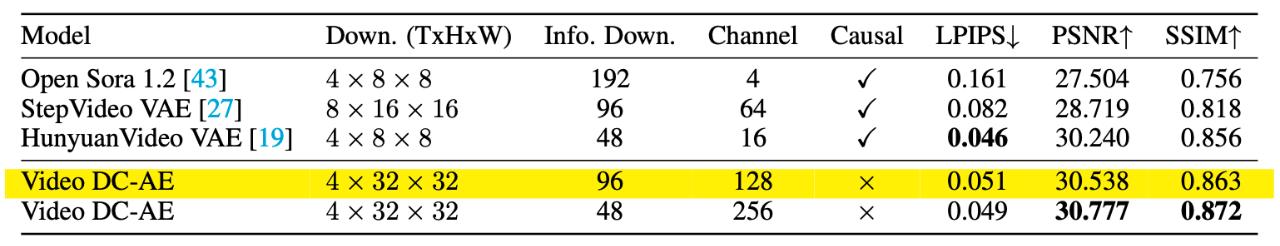

高压缩比 AE 带来更高速度:

Open-Sora 2.0代码:

GitHub 开源仓库:https://github.com/hpcaitech/Open-Sora

技术报告:https://github.com/hpcaitech/Open-Sora-Demo/blob/main/paper/Open_Sora_2_tech_report.pdf