-

论文标题:NoisyGL: A Comprehensive Benchmark for Graph Neural Networks under Label Noise

-

论文地址:https://arxiv.org/pdf/2406.04299

-

项目地址:https://github.com/eaglelab-zju/NoisyGL

论文核心:

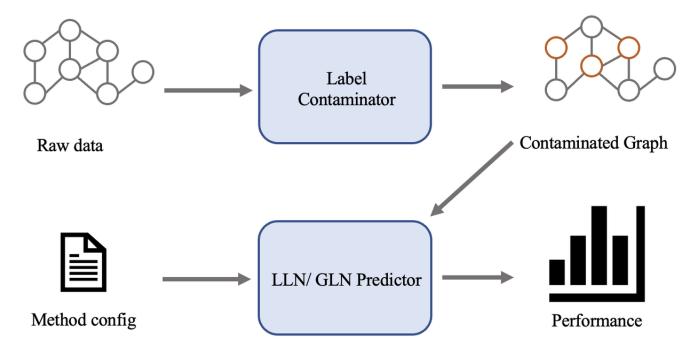

- 提出了 NoisyGL,第⼀个针对标签噪声下的图神经⽹络的综合基准库。

- 通过⼤量的实验,针对标签噪声下的图神经⽹络提出了⼀些重要的见解。

- 为标签噪声下的图神经⽹络提供了⼏点未来的发展⽅向。

GNNs通过消息传递机制在节点分类任务中表现出强大的潜力,但是它们的性能往往依赖于⾼质量的节点标签。在现实任务中,由于不可靠的来源或对抗性攻击,准确的节点标签很难获得。因此,标签噪声在现实世界的图数据中很常见。噪声标签会在训练过程中传播错误信息,从而对 GNNs 产生负⾯影响。

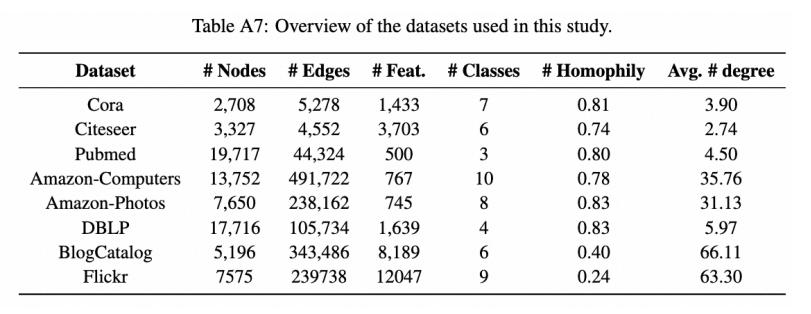

考虑⼀个图G={v,e},其中 V 是包含所有 N 个节点的集合,e是边的集合。A是邻接矩阵,X表示节点特征矩阵,特征的维度为 d 。每个节点都有⼀个真实标签,真实标签集合表示为y={y1*,y2*,y3*,...yn*}。

要是只关注半监督节点分类问题,其中只有⼀小部分节点vL被分配了⽤于训练过程的标签,这部分标签表示为yL={y1*,y2*,y3*...yl*},其中l是有标签节点的数量。其余的则是无标签节点,表示为vu=v-vL。给定 X 和 A ,节点分类的⽬标是通过最小化L(f0(X,A),yL)来训练⼀个分类器f:(X,A)->Y={y1,y2,...,yN}的向量,其中 c 是类别数量,L是衡量预测标签与真实标签之间差异的损失函数。通常是⼀个设计良好的图神经网络。通过这种方式,根据经验风险最小化(Empirical Risk Minimization, ERM)原则,训练良好的节点分类器可以在未⻅数据VU上实现泛化。

不过在现实世界中可访问的标签可能会受到标签噪声的污染,从而降低的泛化能力。我们将噪声标签表示为yN={y1,y2...yl},yL是其对应的真实标签。

考虑两种类型的标签噪声,均匀噪声(Uniform Noise)或对称噪声,对偶噪声(Pair Noise)或对偶翻转、⾮对称噪声。这些噪声模型假设转移概率仅依赖于观察到的标签和真实标签,即与实例特征无关。而在现实世界中,标签噪声可能更加复杂。在这项工作中,我们关注最以上两种常用的噪声类型,将其他噪声类型留给未来的研究。