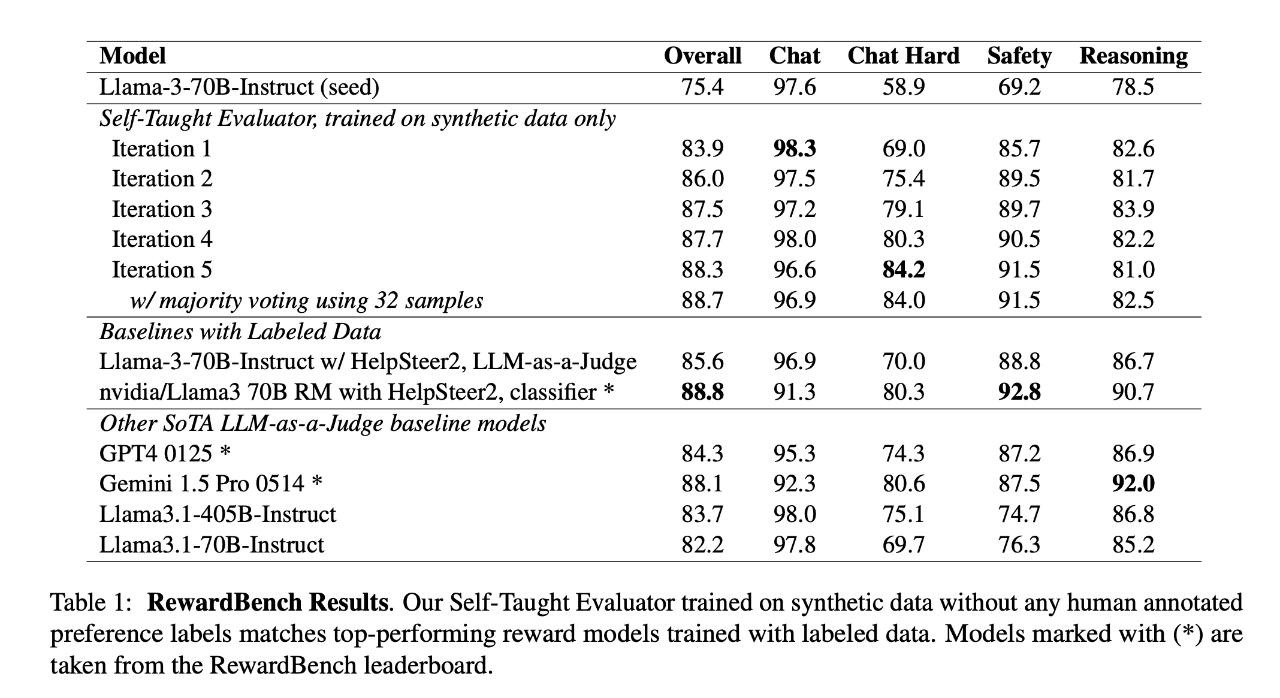

Meta 在 8 月发表了一篇题为《Self-Taught Evaluators》的论文,提出了自学习评估器,用于生成合成偏好数据来训练奖励模型,无需依赖人工标注。

论文链接:https://arxiv.org/abs/2408.02666

代码链接:https://github.com/facebookresearch/RAM/tree/main/projects/self_taught_evaluator

访问合成数据:https://huggingface.co/datasets/facebook/Self-taught-evaluator-DPO-data

模型链接:https://huggingface.co/facebook/Self-taught-evaluator-llama3.1-70B